-

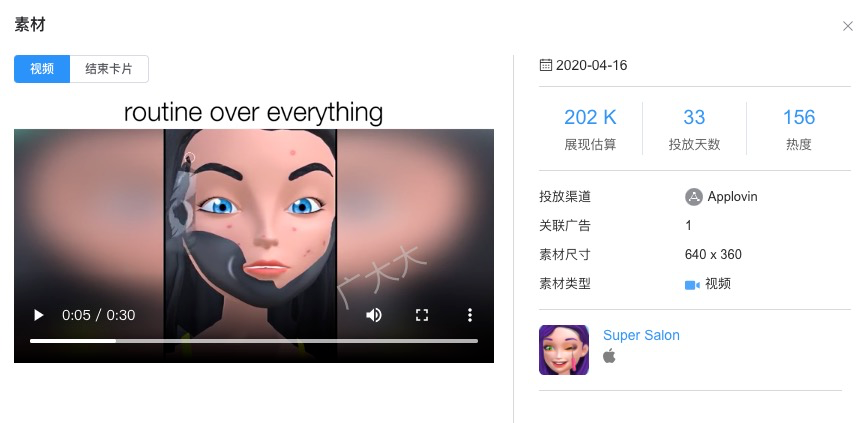

1.3B的稠密模型,适用于资源高度受限的环境

-

3.1B的稠密模型,为边缘部署进行了优化

-

40.3B的混合专家(MoE)模型,专为处理更复杂的任务而设计

现在,LFM模型已经可以免费体验了:

https://playground.liquid.ai

https://lambda.chat/liquid-ai

Attention Is Not All You Need

不过,团队也承认,LFM也有很多不擅长的任务:

- 零样本学习的代码任务

- 精确的数值计算

- 时效性信息

目前,LFM擅长的领域包括:

- 一般知识和专业知识

- 数学和逻辑推理

- 高效且有效的长上下文任务

如何「超越」GPT?

秀丽隐杆线虫的大脑

团队通过理论分析和实验证明,这套系统:

-

是通用近似器(universal approximators)

-

在处理序列数据方面,是具有强大表现力的连续时间机器学习系统

-

在学习新技能方面具有极高的参数效率

-

具有因果性和可解释性

-

在线性化时,可以高效建模序列数据中的超长期依赖关系

全新的模型架构

全新的设计空间

1. token混合结构:算子如何在输入序列中混合嵌入

2. 通道混合结构:如何混合通道维度

推进大规模AI模型的帕累托边界

团队介绍

Ramin Hasani,CEO

Mathias Lechner,CTO

Alexander Amini,CSO

Daniela Rus

Liquid:在每个规模上,创造同类最佳的系统

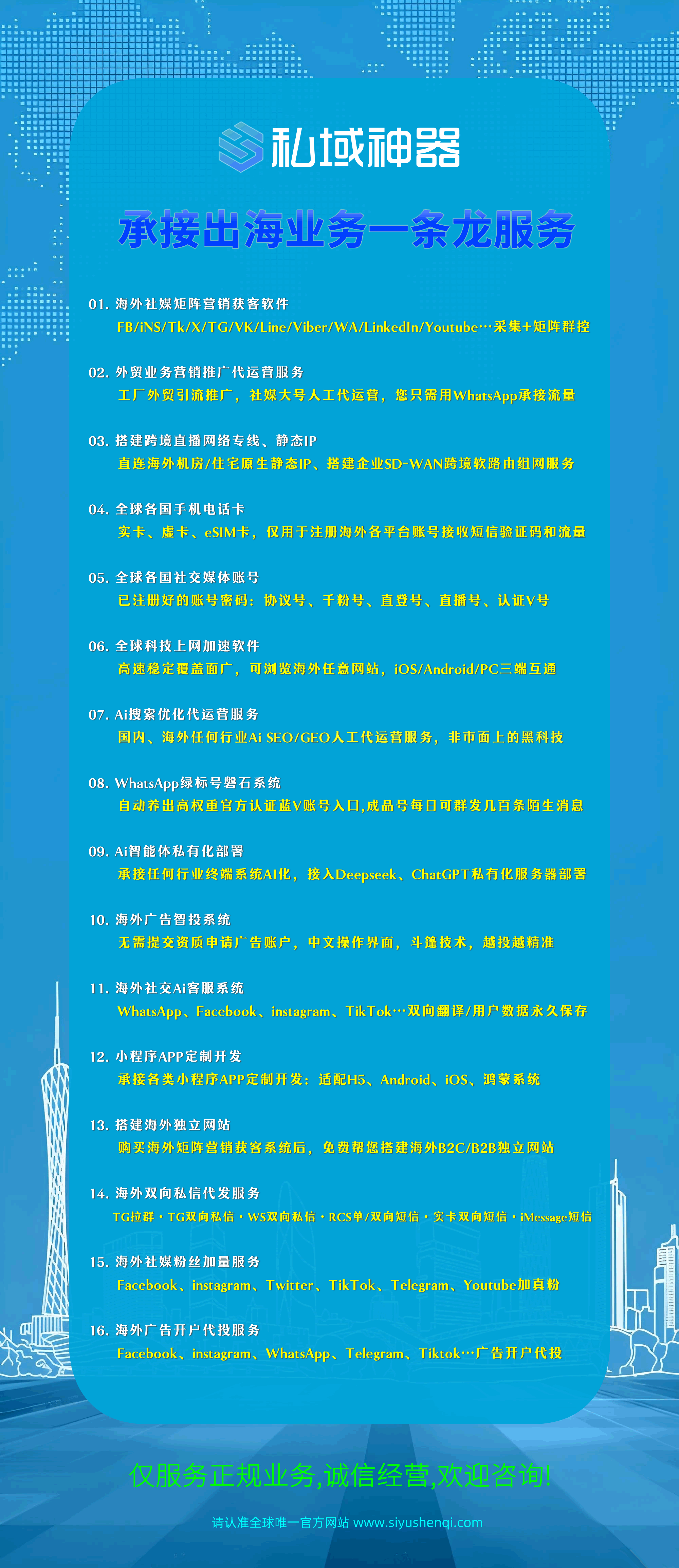

本文源自「私域神器」,发布者:siyushenqi.com,转载请注明出处:https://www.siyushenqi.com/32592.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫