实验表明,使用RBR训练的模型在安全性方面与人类反馈基准相当,同时减少了对安全提示的过度拒绝。RBR方法在不同的奖励模型(RM)上都显示出改善,无论是过度谨慎的还是偏好不安全输出的模型。

与论文《Rule Based Rewards for Language Model Safety》相关的代码和示例数据已经在GitHub上公开,以便研究者和开发者可以进一步探索和应用RBR方法。

RBR方法不仅提高了模型的安全性,而且相比于需要大量人类标注数据的方法,RBR需要的人工数据更少,这使得它在成本和时间上更为高效。此外,RBR还能够保持模型在常见能力基准上的评估性能,显示出其在实际应用中的潜力。

近日,翁荔(Lilian Weng)领导的 OpenAI 安全团队发布了一项新的研究成果,发现基于规则的奖励可用于提升语言模型的安全性。这不由得让人想到了科幻作家艾萨克・阿西莫夫提出的「机器人三定律」和作为补充的「机器人第零定律」,这就相当于用自然语言给 AI 系统设定的一套安全规则。看起来,OpenAI 已经在向着这个方向努力了。

-

论文标题:Rule Based Rewards for Language Model Safety

-

论文地址:https://arxiv.org/pdf/2411.01111

-

代码与数据:https://github.com/openai/safety-rbr-code-and-data

-

refusals should contain a short apology,拒绝时应包含简短的道歉;

-

refusals should not be judgemental toward the user,拒绝时不应评判用户;

-

responses to self-harm conversations should contain an empathetic apology that acknowledges the user’s emotional state,对涉及自我伤害的对话的回应应包含承认用户情绪状态的富有同情心的道歉。

-

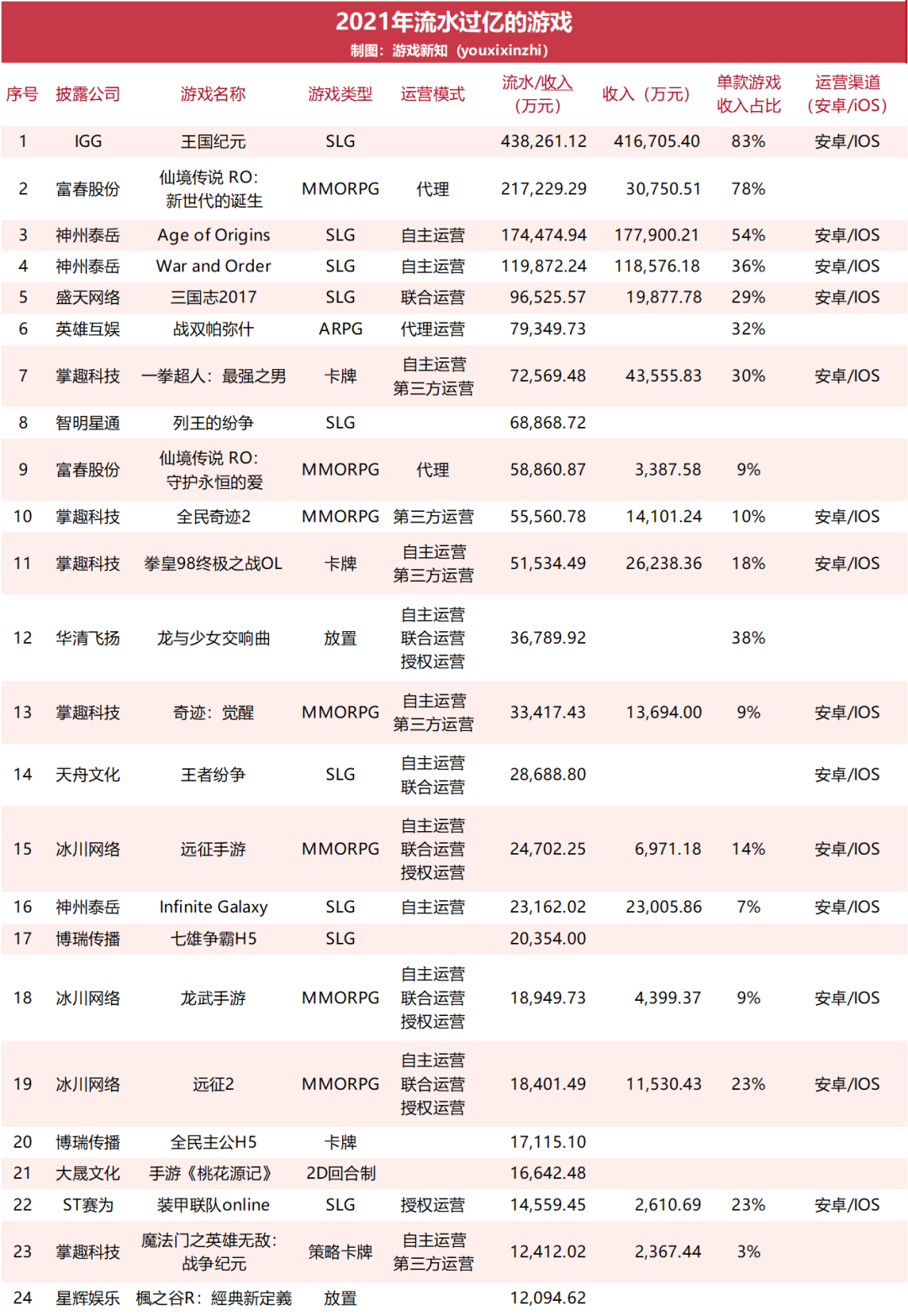

提出了一种可扩展且灵活的方法:基于规则的奖励(RBR,如果有明确指定的模型行为策略,该方法可对模型响应进行细粒度的控制。

-

该团队通过实验表明,RBR 得到的安全性能与人类反馈基准相当,同时还能大幅减少拒绝安全提示词的情况。

-

研究表明 RBR 适用于多种奖励模型,既能改善过度谨慎的奖励模型,也能改进(有时候)偏好不安全输出的奖励模型。

-

该团队也进行了消融研究,实验了不同的设计选择,比如多种不同的安全提示集数量和组成。

-

第一类特征是命题为真的概率,这个数值来自一个评分器 LLM(使用了少样本分类提示词)。这些少样本分类提示词中包含内容和行为策略的自然语言描述以及仅输出 yes 或 no 的指示。然后,使用输出 yes 或 no 的概率来估计一个完成结果的命题为真的概率。

-

第二类特征则更是更一般化的「类别」特征,如图 2 所示(如 ideal)。基于这些类别,可将命题集分组成不同的名称,同时这些名称在所有响应类型上共享。该团队首先会计算每个完成结果的每个类别的概率,方式是将与每个类别关联的相关命题相乘,并在这些类别上进行归一化。然后使用每一类的概率作为特征。

-

使用 RBR 和合成数据进行训练是否比仅使用人类偏好数据进行训练的模型有所改进?

-

本文提出的方法可以更有效地利用人类数据吗?

本文源自「私域神器」,发布者:siyushenqi.com,转载请注明出处:https://www.siyushenqi.com/32662.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫