摘要

快思考模型(如 Turbo S)模拟人类直觉,适合快速回答90%的日常请求;慢思考模型(如混元 T1)则模拟理性思维,适合深度分析和复杂问题解决。两者结合使大模型更智能高效。Turbo S 借鉴了混元 T1 的长思维链数据,通过多步骤推理提升对复杂问题的处理能力。

混元 Turbo S 采用 Hybrid-Mamba-Transformer 融合架构,结合了 Mamba(高效处理长序列)和 Transformer(擅长复杂推理)的优点,降低了计算复杂度和 KV-Cache 缓存占用,提升了训练和推理效率。这一架构创新使其在知识、数学、推理等领域表现出色,成本大幅降低。

Turbo S 通过长短思维链融合和算法优化,提升了模型在数学、代码、逻辑等强推理任务上的表现。同时,其成本显著低于其他同类模型,输入价格为0.8元/百万 tokens,输出价格为2元/百万 tokens,相比前代混元 Turbo 模型和 Deepseek API 成本更低。

Turbo S 的出现旨在平衡响应速度与成本,满足市场对快速、低成本 AI 模型的需求。腾讯混元团队认为,模型规模和训练数据的 scaling law 远未结束,未来将继续探索数据、算法和算力优化,以提升模型性能。

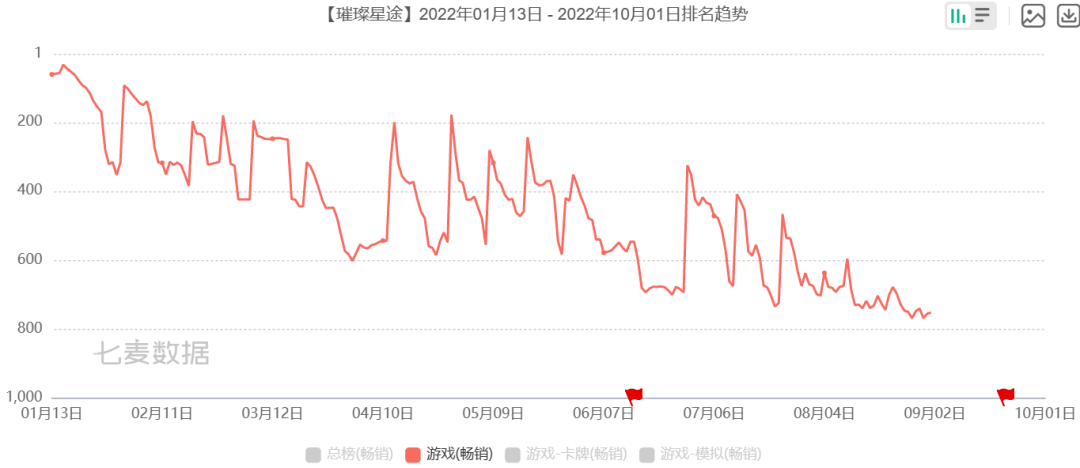

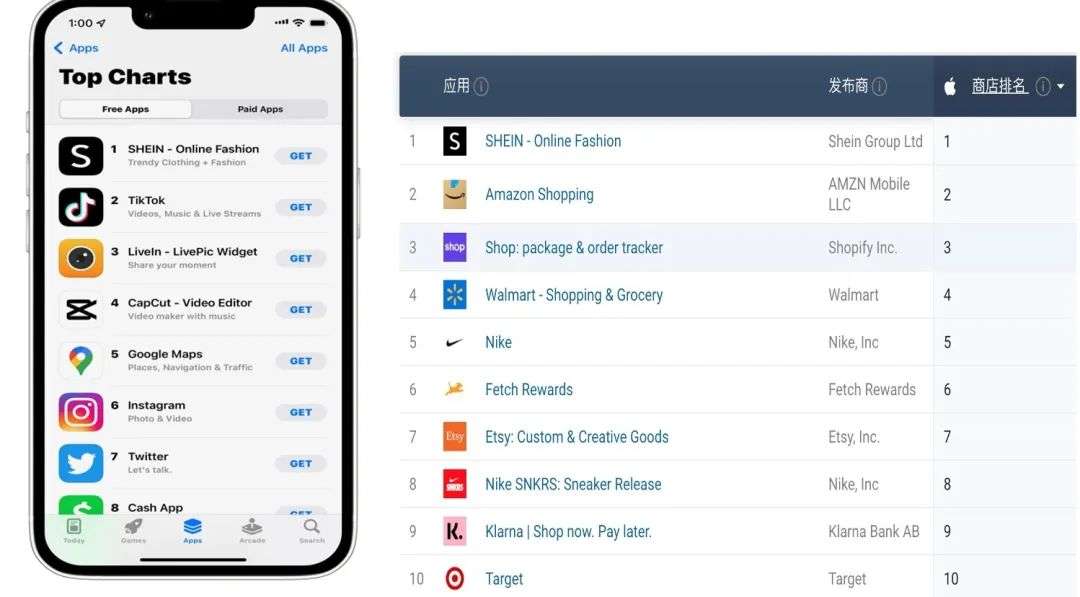

最近,腾讯元宝可以说是「杀疯了」,先是多款产品接入 deepseek,推出自研混元 T1 模型,又是猛推流,一度超越字节「豆包」登上中国区 App Store 免费榜第二,又是入驻微信生活服务「九宫格」。

01

02

03

04

不管是模型 size 的 scaling 还是训练数据的 scaling,目前 scaling law 远未结束,现在中文互联网上可获取数据量各家差不多,谁能通过获取或合成方式获得更多数据量对模型 performance 来说是关键。

本文源自「私域神器」,发布者:siyushenqi.com,转载请注明出处:https://www.siyushenqi.com/32924.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫