摘要

原生分辨率 ViT 拒绝拉伸变形,自适应 MLP 连接器剪除 80% 冗余 Token,0.5B XD-RoPE LLM 原生理解二维/三维版面。

覆盖 130 种语言、9 大场景,Synthdog 深度渲染+Warping 实战扰动,自动生成难例 VQA,解决长尾稀缺。

50B→3T Token 逐步解锁多模态、长上下文与格式规范,用 IoU+编辑距离+大模型裁判精准奖励,轻量模型也能持续进化。

Spotting、Parsing、IE、VQA、翻译 5 大公开基准全第一,仅用 1B 参数就超越 Qwen3-VL-235B、Gemini-2.5-Flash 等数百亿级模型,推理成本降至 1/200。

腾讯 HunyuanOCR 仅用 1B 参数的端到端架构,彻底解决了传统 OCR 级联误差和通用大模型效率低下的双重难题。

HunyuanOCR 摒弃了复杂的流水线设计,采用纯粹的端到端(End-to-End)视觉语言模型(Vision-Language Model, VLM)架构。

在仅有 10 亿(1B)参数的规模下,它不仅在基础的文本定位和解析任务上超越了现有的商业 API,还在信息提取、视觉问答等高阶任务中,展现出与数百亿参数模型比肩的性能。

端到端架构设计的减法艺术

长期以来,工业界的 OCR 系统像一座复杂的工厂。

为了处理一张文档图片,我们需要文本检测模型先找到字,文本识别模型认出字,版面分析模型搞清楚段落结构,表格识别模型处理网格,公式识别模型处理数学符号。

这种流水线架构看似分工明确,实则隐患重重。

检测偏了一像素,识别就可能错一个字;版面分析搞错一行,整个文档的阅读顺序就乱了。

这种多米诺骨牌式的误差累积,是传统 OCR 难以根除的顽疾。

通用多模态大模型虽然能解决部分问题,但动辄几百亿的参数量,让推理成本高不可攀,且在处理高分辨率文档细节时常常力不从心。

HunyuanOCR 选择了做减法。

整个系统被压缩为三个核心组件:原生分辨率视觉编码器、自适应 MLP 连接器、轻量级语言模型。

没有复杂的预处理,没有繁琐的后处理,图像进,结果出。

这种设计不仅在工程上极大地简化了部署流程,更在数学原理上消除了中间环节的误差损耗。

视觉编码器(Hunyuan-ViT)是这套架构的眼睛。

它建立在 SigLIP-v2-400M 预训练模型之上,参数量约为 0.4B。

与传统模型强制将图片缩放到固定尺寸不同,Hunyuan-ViT 拥有原生分辨率的处理能力。

它采用自适应分块(Adaptive Patching)机制,像拼图一样处理图像。

当面对一张长条形的购物小票,或者一张宽幅的全景街景时,模型不会粗暴地拉伸或压缩图片,而是根据图像原始的宽高比将其切分为多个 Patch。

这些 Patch 随后进入视觉 Transformer(ViT)进行全局注意力计算。

这种对原始比例的尊重,确保了图像中的微小文字不会因为变形而模糊,长文档的边缘信息不会丢失。这对于 OCR 任务至关重要,因为文字识别对分辨率的敏感度远高于普通物体识别。

连接器(Adaptive MLP Connector)是架构中的压缩机。

视觉编码器产生的高分辨率特征图虽然信息丰富,但直接喂给语言模型会造成巨大的计算浪费。

大部分文档图片中存在大量的空白区域,这些区域不包含语义信息。

自适应 MLP 连接器在视觉域和语言域之间架起桥梁。

它不仅仅是一个简单的投影层,更执行了一种核心的可学习池化操作。它在空间维度上对内容进行自适应压缩,智能地识别出哪些区域是文本密集的关键区域,哪些是冗余背景。

通过这种压缩,Token 序列的长度被大幅削减,而关键的语义信息得以保留。这意味着语言模型只需要处理干货,从而在保持 1B 参数轻量级的同时,实现了极高的推理效率。

语言模型(LLM)是系统的大脑。

这部分基于密集架构的 Hunyuan-0.5B 模型构建。

普通的语言模型将文本视为一维序列,但在 OCR 任务中,文字在页面上的位置(二维)甚至视频中的时间(三维)同样重要。

HunyuanOCR 引入了 XD-RoPE 技术,将位置编码玩出了新花样。

它不再使用单一的旋转位置编码(RoPE),而是将其解构为四个独立的子空间:文本、高度、宽度、时间。

这种设计建立了一种原生的对齐机制。一维的文本序列、二维的页面布局、三维的时空信息,在模型内部被统一映射。

这使得模型不仅能读懂字,还能看懂版面。它可以轻松处理多栏排版,理解跨页文档的逻辑联系,甚至在视频帧中追踪文字的轨迹。这种对空间关系的深刻理解,是其在复杂文档解析任务中脱颖而出的关键。

数据工程构建

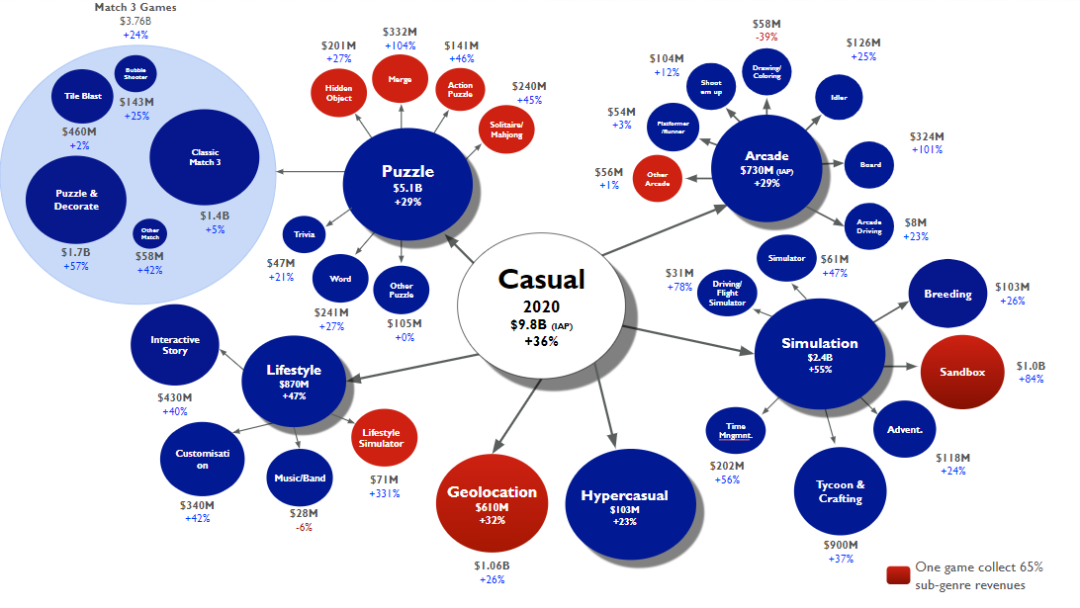

模型架构决定了上限,数据质量决定了能走多远。HunyuanOCR 团队构建了一个规模庞大的数据护城河,包含超过 2 亿个高质量的图像-文本对。

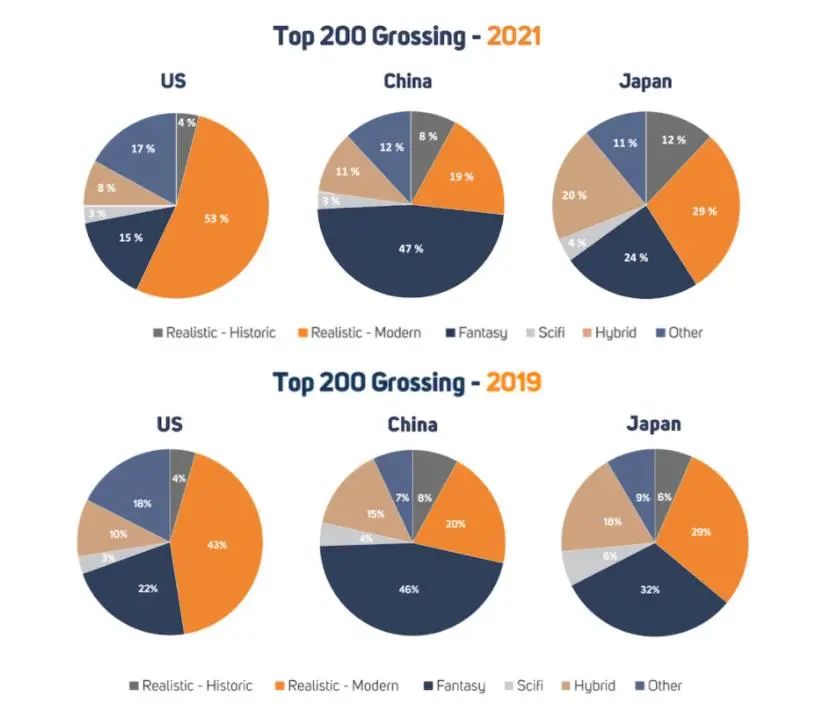

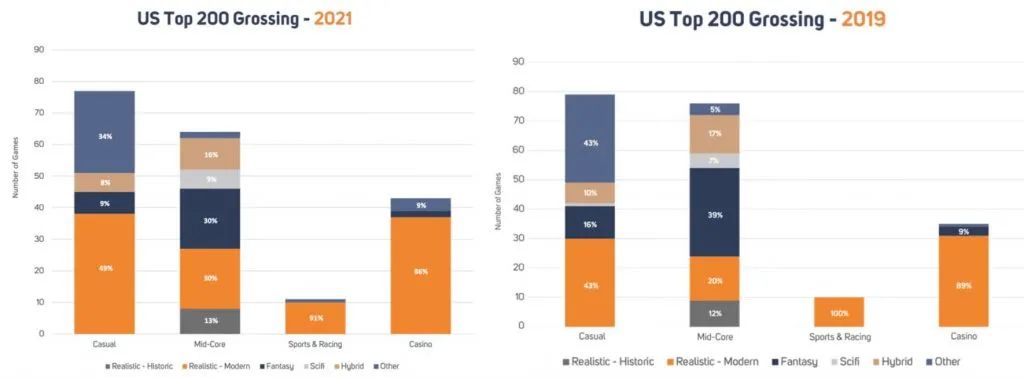

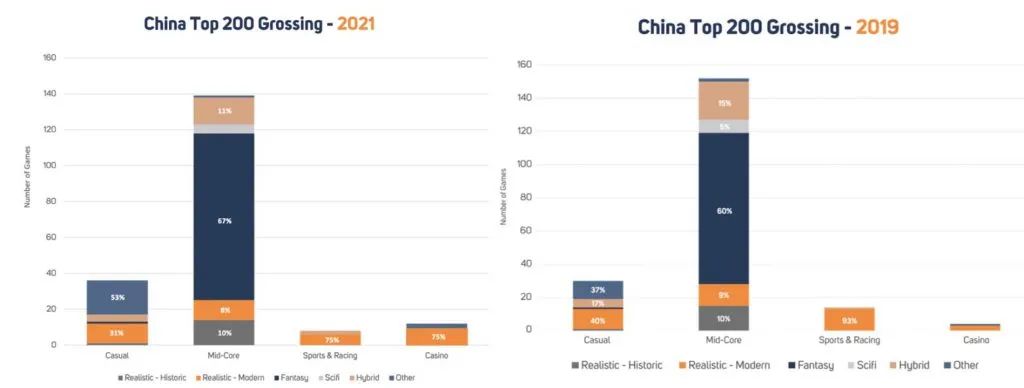

这些数据并非杂乱无章的堆砌,而是覆盖了九大核心场景:街景、文档、广告、手写文本、截屏、卡证发票、游戏界面、视频帧、艺术字体。语言覆盖范围更是超过了 130 种。

合成数据在其中扮演了关键角色。

基于 SynthDog 框架,团队开发了一套强大的合成流水线。它不仅仅是把文字贴在背景上,而是进行深度渲染。

对于低资源语言,系统支持超过 130 种语言的段落级生成,无论是从左到右的常规文本,还是阿拉伯语这种从右到左(RTL)的文本,甚至是复杂的草书手写体,都能精确模拟。

这套系统拥有细粒度的控制力。它可以调整字体风格、颜色、排列方向,模拟真实世界中千奇百怪的排版。

这种合成数据的注入,极大地提升了模型在面对罕见语言和复杂字体时的泛化能力,解决了真实数据中长尾样本稀缺的问题。

为了让模型适应真实的物理世界,团队开发了内部的扭曲合成流水线(Warping Synthesis Pipeline)。

真实用户拍摄的文档往往并不完美。纸张会有折痕,拍摄会有透视变形,光线可能不均匀,甚至会有阴影遮挡。扭曲流水线通过控制点操作模拟几何变形,通过高斯噪声和运动模糊模拟成像质量下降,通过光照扰动模拟阴影和反射。

经过这套流水线处理的数据,让模型仿佛在各种恶劣环境下进行了数百万次的实战演练。当模型在现实中遇到一张皱皱巴巴、光线昏暗的小票时,依然能够精准识别。

在视觉问答(VQA)数据的构建上,团队展示了极高的效率。

他们开发了一套自动化流水线,集成了难例检索、QA 生成和一致性验证。这条流水线遵循单一来源,多种用途的原则。对于同一张图像,它的定位信息、解析结果和 VQA 标注被联合管理。

系统会特意寻找那些难啃的骨头:低清晰度的图片、复杂的嵌套表格、密集的数学公式、冷门语言的代码片段。对于这些难例,系统利用高性能视觉模型自动生成问答对。

为了保证质量,一致性验证机制会引入多个模型进行交叉打分。只有那些逻辑自洽、置信度高的数据才能进入训练集。这种高强度的数据筛选,确保了模型学到的是真知识,而不是噪声。

四阶段训练与强化学

HunyuanOCR 的训练过程像是一场精心编排的四重奏。

第一阶段是视觉与语言的破冰。

在这个阶段,语言模型保持冻结,仅训练视觉编码器和适配器。

使用了约 500 亿(50B)Token。训练数据主要是图像描述和合成 OCR 数据。目的是让视觉编码器学会说话,将看到的像素特征对齐到文本语义空间。

这个阶段不仅要认字,更要学会解析结构,奠定模型对图像感知的基本功。

第二阶段是多模态能力的全面解锁。

所有模型参数解冻,进行端到端的联合学习。训练数据量激增至 3000 亿(300B)Token。数据类型变得丰富多样,涵盖了解析、定位、翻译、VQA 等多任务。

模型开始深入理解文档、表格、图表等结构化内容。为了防止模型忘本,训练数据中始终保留了约 10% 的纯文本数据,维护其语言理解和指令遵循的能力。

第三阶段是长上下文的耐力训练。

上下文窗口被扩展至 32k Token。这相当于让模型具备了阅读整本书的能力。使用了 800 亿(80B)Token,引入了长文档解析任务和长篇纯文本。

模型在这个阶段学会了如何在长长的 Token 序列中保持注意力,理解跨页面的文档逻辑,处理那些篇幅巨大的合同或论文。

第四阶段是面向应用的实战演习。

使用 240 亿(24B)Token 进行监督微调(SFT)。

数据来源是精心策划的人工标注真实世界数据,以及少量高质量合成样本。

在这个阶段,所有任务的指令模板和输出格式被标准化。模型学会了如何像一个专业助手一样,用规范的格式(如 Markdown、LaTeX、JSON)输出结果,确保在实际应用中的可用性。

在预训练之后,强化学习(RL)成为了提升性能的关键一跃。

HunyuanOCR 采用了群体相对策略优化(GRPO)算法。与传统的强化学习主要用于推理模型不同,这里将 RL 引入了轻量级 OCR 模型。

数据筛选强调难度平衡,剔除了那些无论怎么做都对或者都错的无效样本,以及容易被猜对的选择题。

对于文本定位任务,奖励不再仅仅看字对不对,还要看框准不准。奖励计算结合了预测框与真实框的交并比(IoU)以及文本内容的归一化编辑距离。只有框得准、认得对,才能拿高分。

对于文档解析,奖励基于编辑距离,严格考核结构的完整性。少了一个表头,错了一个公式符号,都会导致奖励骤降。

对于翻译任务,引入了评分大模型作为裁判,给出 0 到 5 分的打分,并进行去偏归一化。这使得模型能够感知到翻译质量的细微差别,追求信达雅。

在 GRPO 训练中,严格的格式约束被强制执行。任何不符合 JSON 格式或超出长度限制的输出,直接归零。这逼迫模型在探索最优解的同时,必须严格遵守输出规范。

任务定义的标准化与统一

HunyuanOCR 将原本割裂的 OCR 任务统一到了自然语言指令的框架下。

在文本定位(Spotting)任务中,用户只需输入固定指令:Detect and recognize text in the image...。

模型便会输出结构化的 <ref>text</ref><quad>coordinates</quad> 格式。坐标被归一化到 [0, 1000],无论图片分辨率如何,输出坐标始终精确对应。

文档解析(Parsing)任务被细化到了极致。

遇到数学公式,模型输出标准的 LaTeX 代码;遇到表格,输出 HTML 源码;遇到流程图,输出 Mermaid 代码。

对于全文档解析,模型会忽略页眉页脚的干扰,按阅读顺序提取所有信息,并自动将公式、表格转换为对应的代码格式,最终生成一个干净、结构化的 Markdown 文档。

这直接对接了下游的 RAG(检索增强生成)系统,极大地降低了数据清洗的成本。

信息提取(IE)任务展现了强大的指令遵循能力。

用户可以要求提取特定字段(提取发票金额),也可以提供一个键列表(Key List),要求模型以 JSON 格式批量提取多个字段。

对于视频字幕,模型能够适应各种分辨率和屏幕位置,精准捕捉每一句台词。

文本图像翻译任务打破了语言的界限。

支持超过 14 种源语言到中文或英文的互译。

针对不同场景,设计了两种提示词范式。对于路牌、菜单等场景文本,使用通用翻译提示词;对于复杂文档,使用文档导向提示词,先解析结构再翻译内容,确保翻译后的文档依然保留原本的表格和公式排版,实现了所见即所得的翻译体验。

性能数据的全面碾压

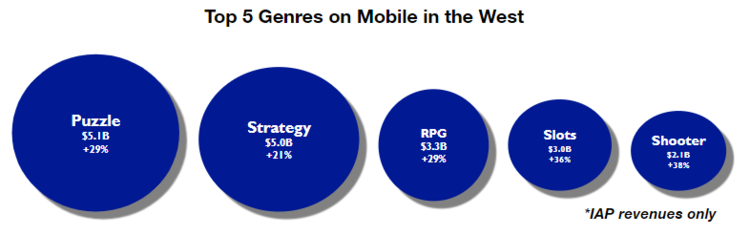

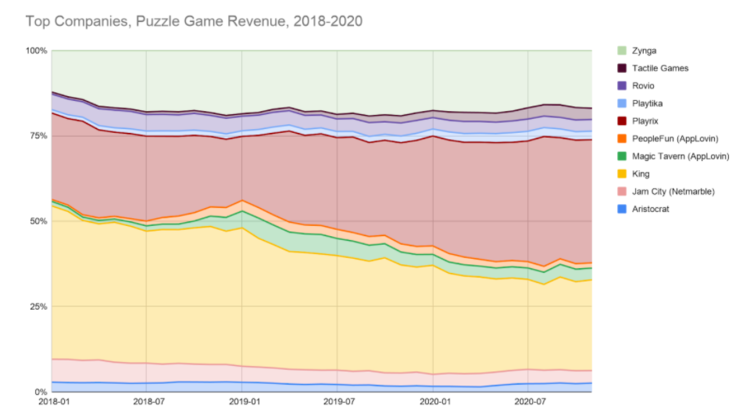

HunyuanOCR 在各项基准测试中交出了令人信服的答卷。

在文本定位(Spotting)方面,HunyuanOCR 在包含 900 张多场景图片的内部测试集中,总分达到 70.92。

这一成绩不仅超越了传统霸主 PaddleOCR(53.38)和 BaiduOCR(61.90),也击败了参数量巨大的 Qwen3-VL-235B(53.62)。

特别是在艺术字、手写体和视频帧这些老大难场景中,HunyuanOCR 的优势尤为明显,证明了其原生分辨率编码器的强大鲁棒性。

在文档解析(Parsing)领域,HunyuanOCR 展现了统治力。

在 OmniDocBench 基准测试中,它以 94.10 的高分傲视群雄,超过了 PaddleOCR-VL(92.86)和 MinerU2.5(90.67)。

即使在包含折叠、弯曲等极端情况的 Wild-OmniDocBench 测试中,它依然保持了 85.21 的分数,远超 Qwen3-VL-235B 的 79.69。这说明它不仅能读懂扫描件,也能读懂生活中的随手拍。

在信息提取(IE)与视觉问答(VQA)任务上,效率优势尽显。

在卡片和票据的提取任务中,准确率分别高达 92.29% 和 92.53%。

相比之下,Qwen3-VL-235B 仅为 75.59% 和 78.4%。用 1/200 的参数量,实现了更高的业务精度。

在 OCRBench 公开榜单上,HunyuanOCR 得分 860,在小于 3B 参数的模型中遥遥领先,大幅超越 DeepSeek-OCR 的 430 分。

文本图像翻译的成绩同样亮眼。

在 DoTA 文档翻译数据集上,其中文到英文的翻译得分为 83.48(COMET 指标)。

这一成绩超过了 Qwen3-VL-235B(80.01),甚至优于 Gemini-2.5-Flash。

在多语言翻译测试中,尽管参数量仅为 1B,它依然击败了 4B 和 2B 规模的 Qwen3-VL 模型,证明了高质量数据和端到端训练在跨语言任务上的巨大潜力。

HunyuanOCR 用 10 亿参数的精巧身躯,承载了商业级的 OCR 性能。

本文源自「私域神器」,发布者:siyushenqi.com,转载请注明出处:https://www.siyushenqi.com/69256.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫